大多数网站管理员为了让网站服务器可以持久稳定的运行,一般会制定很多防护策略,诸如访问次数或访问频率等策略。网络爬虫往往工作任务比较大,访问量会很大,访问频率也很快,若是只有一个IP来访问,很快就会被限制访问,因此需要代理IP来协助工作。下面主要给大家介绍下关于python爬虫使用代理IP,希望对大家有所帮助。

一、爬虫代码中使用代理ip

proxies = {

'http':'http://168.168.168.168:10068',

'https':'http://168.168.168.168:10068'

}

requests.get(url, headers=headers, proxies=proxies, timeout=3)二、检验代理ip是否生效

我们访问一个网站,这个网站会返回我们的ip地址:

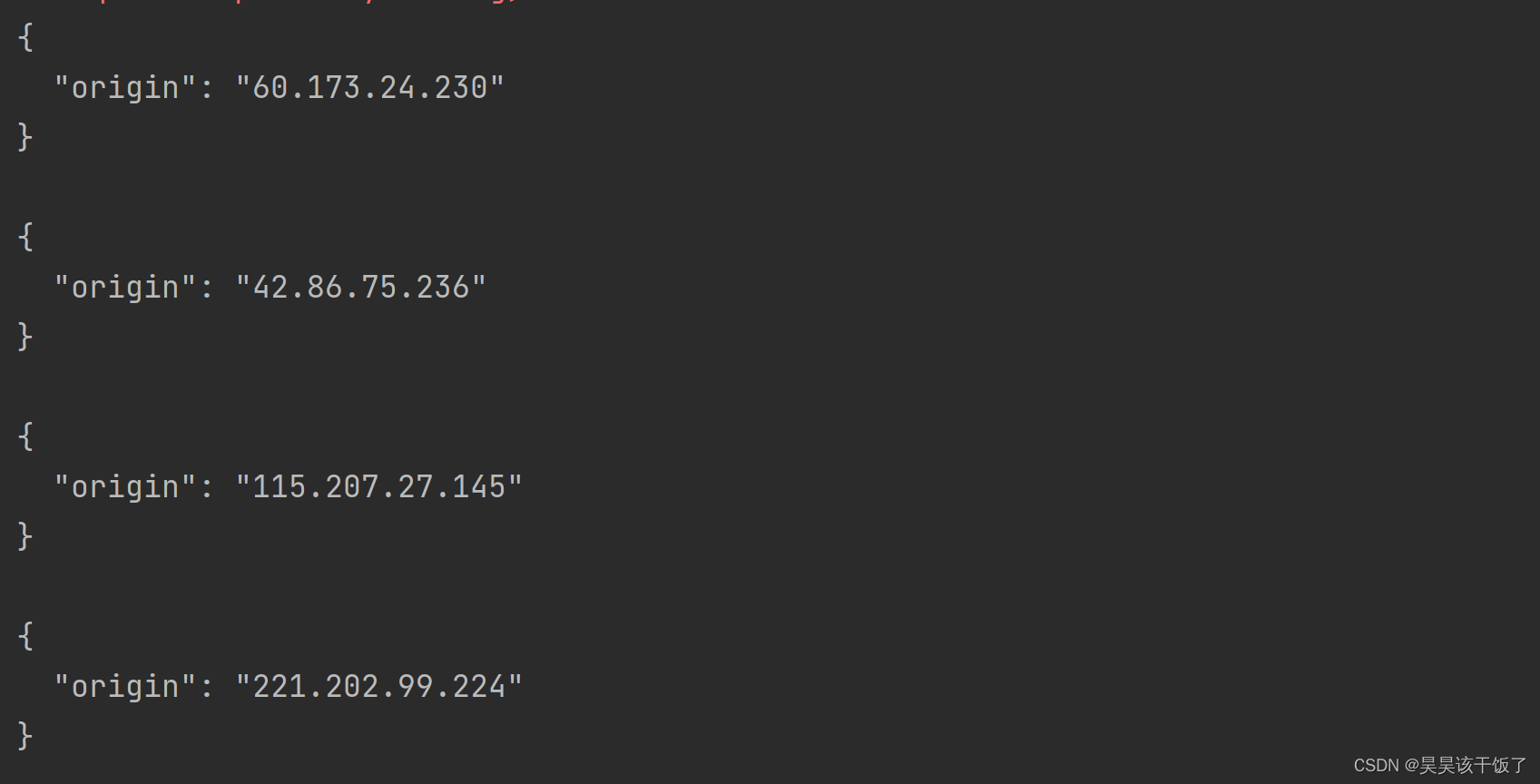

print(requests.get('http://httpbin.org/ip', proxies=proxies, timeout=3).text)我们看一下我使用了四个不同的代理ip,全部生效了,

三、代理IP未生效原因

如果你返回的还是本机地址,或者请求失败,那么极有可能是以下两种情况:

1.请求协议不匹配

简单来说就是,如果你请求的是http网址,就要用http的协议,如果是https网址,就要用https的协议。

如果是请求http网址 ,但proxies里只使用了https协议,那么就会使用本机ip。

2.代理IP失效

如果请求失败报错,那么有可能是代理IP失效了,也有可能是代理IP授权失败(高质量代理ip往往需要先授权才能使用)等原因,具体是什么原因,需要根据报错信息来判断。

以上就是关于Python使用代理IP的一些说明,若有其他疑问,可以联系客服寻求帮助。站大爷专业提供企业级高品质代理IP,欢迎大家前来咨询选购。