一、引言

在如今这个大数据时代,信息的获取与处理能力是企业提升竞争力的关键因素。然而,随着网站反爬虫技术的日益成熟,传统的单机爬虫在面对大规模数据采集任务时显得力不从心。

分布式爬虫是一种更高效的数据采集工具,它有强大的并发能力和可扩展性,而代理IP则为分布式爬虫的稳定运行和高效采集提供了坚实保障。

二、分布式爬虫的概念

分布式爬虫是一种利用多台计算机协同工作的数据采集系统。它通过中央化的任务调度器,将复杂的抓取任务智能地分配给各个独立的爬虫节点。每个节点在接收到任务后,独立执行数据抓取操作,并将结果汇总至统一的数据存储系统。

这种分布式的设计不仅极大提升了数据抓取的速度,还增强了系统的稳定性与容错能力,即使某个节点出现故障,整个系统仍能持续运行。

三、代理IP池的构建

为确保分布式爬虫能够持续、稳定地工作,构建一个高效可靠的代理IP池非常重要。代理IP池是一个动态维护的代理IP集合,它负责为爬虫节点提供可用的代理IP地址,以应对网站的反爬虫策略。

在构建代理IP池时,需充分考虑代理IP的可用性、速度、稳定性以及来源的合法性。通过定期更新和维护,确保池中的代理IP始终保持较高的可用性。此外,为了进一步提高效率,可以引入代理IP验证机制,自动剔除无效的代理IP,同时动态添加新的有效代理IP。

示例代码:

import requests

from collections import deque

class ProxyPool:

def __init__(self):

# 使用deque作为代理IP队列,便于从两端添加和移除元素

self.proxy_queue = deque()

def add_proxy(self, proxy):

"""添加代理IP到队列中"""

self.proxy_queue.append(proxy)

def remove_proxy(self):

"""从队列中移除并返回一个代理IP,如果队列为空则返回None"""

if self.proxy_queue:

return self.proxy_queue.popleft()

return None

def verify_proxy(self, proxy):

"""简单验证代理IP是否可用,这里仅作为示例,实际验证可能需要更复杂的逻辑"""

try:

# 使用一个公共HTTP接口来测试代理IP是否可用

# 注意:这里使用'httpbin.org/get'作为示例,实际使用时请替换为合适的测试URL

response = requests.get('http://httpbin.org/get', proxies={'http': proxy}, timeout=5)

if response.status_code == 200:

# 假设状态码200表示代理IP可用

return True

except requests.exceptions.RequestException:

# 捕获请求异常,如超时、连接错误等

pass

return False

def get_valid_proxy(self):

"""从队列中获取一个有效的代理IP,如果队列中没有有效代理,则返回None"""

while self.proxy_queue:

proxy = self.remove_proxy()

if self.verify_proxy(proxy):

return proxy

return None

def refresh_proxies(self, new_proxies):

"""添加新的代理IP列表到池中,并进行验证"""

for proxy in new_proxies:

if self.verify_proxy(proxy):

self.add_proxy(proxy)

# 示例用法

proxies = ['http://123.123.123.123:8080', 'http://156.156.156.156:8080']

# 假设这是新收集到的代理IP列表,实际上可以通过站大爷的API接口获取

proxy_pool = ProxyPool()

proxy_pool.refresh_proxies(proxies)

# 尝试获取一个有效的代理IP

valid_proxy = proxy_pool.get_valid_proxy()

if valid_proxy:

print(f"获取到有效的代理IP: {valid_proxy}")

else:

print("当前没有可用的代理IP")四、分布式爬虫架构设计

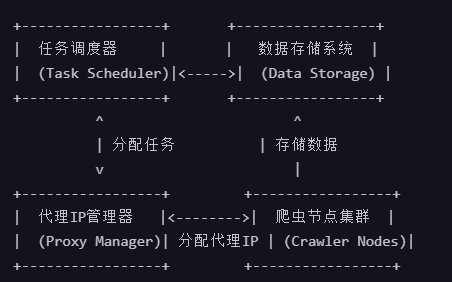

一个完善的分布式爬虫系统,通常包括爬虫节点、任务调度器、数据存储系统以及代理IP管理器等核心组件。这些组件相互配合,共同构成了高效稳定的数据采集网络。

爬虫节点:负责具体的数据抓取任务,每个节点独立运行,可根据需求进行扩展或缩减。

任务调度器:作为系统的中枢,负责将抓取任务分配给各个爬虫节点,确保任务的有序执行和负载均衡。

数据存储系统:用于集中存储爬虫抓取到的数据,便于后续的分析和处理。

代理IP管理器:负责代理IP池的构建、维护以及动态分配,确保爬虫节点在遭遇IP封锁时能够迅速切换代理IP,继续执行抓取任务。

分布式爬虫相比单机爬虫的优势在于其强大的并发能力和可扩展性。通过增加爬虫节点的数量,可以显著提高数据抓取的速度和效率。同时,分布式爬虫还具有良好的容错性,即使某个节点出现故障,也不会影响整个系统的正常运行。

示例:基于代理IP的分布式爬虫简易架构设计

在这个架构中,代理IP管理器起到了桥梁的作用,它连接了任务调度器和爬虫节点,确保了整个系统的稳定运行。通过合理使用代理IP,可以显著提高分布式爬虫的效率、稳定性和安全性。

五、总结

在分布式爬虫设计中,代理IP的重要性不言而喻。通过合理选择和使用代理IP,可以突破IP访问限制、提高爬虫效率、保护爬虫服务器安全。