爱美之心,人皆有之。一张高清美女图片往往能够令人赏心悦目,心情愉悦。然而,面对海量的图片资源,如何快速、准确地找到并下载符合需求的图片呢?本文将带你使用Python编写爬虫程序,通过代理IP批量下载高清美女壁纸。

一、关键步骤

确定关键词:设置你想要下载图片的关键词,例如"职场美女"、"动漫美女"等。

选择图片源:选择一个允许爬取的高清美女图片网站,并确保遵守该网站的使用条款。

编写爬虫代码:使用Python中的requests库发起网络请求,以及利用BeautifulSoup或lxml库进行HTML内容解析。

使用代理IP:频繁的下载图片很容易受到限制,建议部署一个代理IP池,通过动态切换IP地址来规避IP封锁的风险。

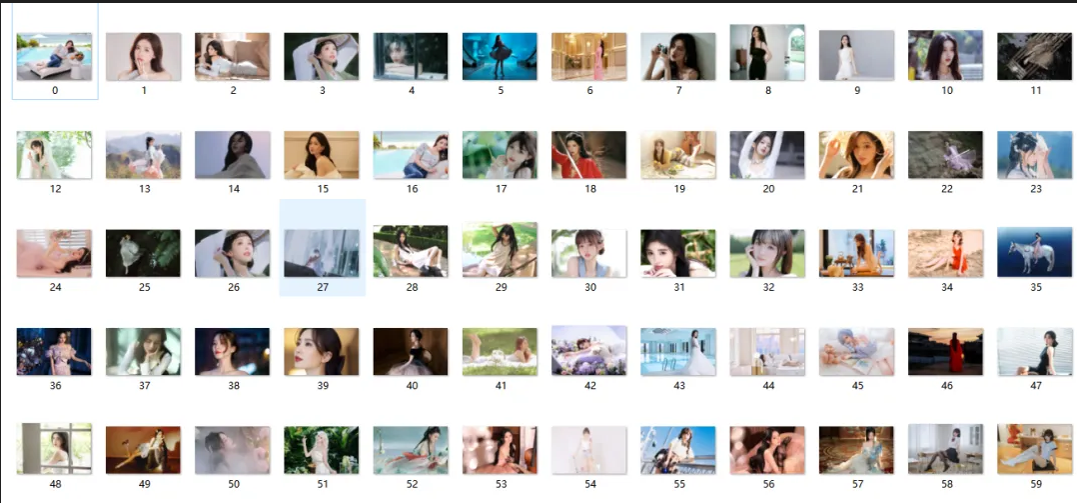

图片下载:编写Python脚本,从解析出来的图片地址中抓取图片,并将其存储到指定的目录中。

错误处理:添加错误处理机制,确保在遇到异常时程序也能继续运行,从而提高整体的稳定性和可靠性。

二、准备工作

第三方模块:安装requests、beautifulsoup4、lxml等必要模块。

pip install requests beautifulsoup4 lxml pandas fake-useragentRequests:用于发送HTTP请求。

BeautifulSoup4:用于解析HTML和XML文档(本文使用lxml解析器)。

lxml:一个高效的XML和HTML解析库。

Pandas:数据分析库,有时用于处理爬取的数据(本文未使用)。

fake-useragent:用于生成随机的用户代理(本文未使用,但有助于规避IP被封的风险)。

代理IP:准备代理IP池,可以使用在线服务或购买专业代理。

自动获取代理IP:通过API接口自动获取代理IP。

import requests

def get_proxy(api_url):

"""

获取代理IP

:param api_url: 代理API的链接,可在站大爷后台的实例管理生成

:return: 返回代理IP的字典

"""

response = requests.get(api_url)

if response.status_code == 200:

proxy_data = response.json()

return {

"http": f"http://{proxy_data['ip']}",

"https": f"http://{proxy_data['ip']}"

}

else:

return None这段代码定义了一个函数‘get_proxy’,它接受一个参数‘api_url’,这是一个代理API的链接。函数通过发送GET请求到这个链接来获取代理IP,如果请求成功(HTTP状态码为200),它会解析返回的JSON数据,并将IP地址格式化为HTTP和HTTPS代理格式,然后返回一个包含这两个代理的字典。如果请求不成功,则返回 ‘None’。

三、编写代码

1.导入模块:导入必要的Python模块。

import requests

from lxml import etree

import time

import os‘requests’模块用于发送网络请求,如向目标网站发出请求;‘lxml.etree’ 用于解析和操作XML/HTML文档,如解析目标网站返回的内容;‘time’模块提供时间相关的功能,如每请求一次休息几秒钟; ‘os’ 模块则用于执行操作系统级别的操作,如指定存放下载图片的路径。

2.设置翻页:分析网站的翻页机制,并构建循环来构造所有网页链接。

def create_urls(page_number):

"""

生成所有网页链接

:param page_number: 总页数

:return: 链接列表

"""

urls = []

for i in range(1, page_number + 1):

if i == 1:

url = 'https://pic.netbian.com/4kmeinv/index.html'

else:

url = f'https://pic.netbian.com/4kmeinv/index_{i}.html'

urls.append(url)

return urls

# 总共62页

page_number = 62

urls = create_urls(page_number)这段代码定义了一个函数 ‘create_urls’,它接受一个参数 ‘page_number’,表示总页数。函数会生成一个包含所有页面链接的列表。

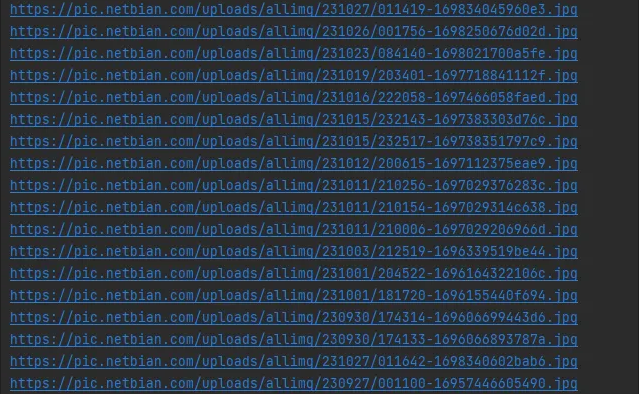

3、下载每页的图片:编写函数来下载每页中的所有图片。

import requests

from lxml import etree

import os

def download_page(url, proxies=None):

"""

下载指定页面的图片

:param url: 页面链接

:param proxies: 代理IP字典

"""

response = requests.get(url, proxies=proxies)

if response.status_code == 200:

tree = etree.HTML(response.text)

images = tree.xpath('//img[@lazy]')

for img in images:

img_url = img.xpath('./@lazy')[0]

download_image(img_url, proxies)

else:

print(f'页面下载失败:{url}')

def download_image(img_url, proxies=None):

"""

下载图片

:param img_url: 图片链接

:param proxies: 代理IP字典

"""

response = requests.get(img_url, proxies=proxies, stream=True)

if response.status_code == 200:

image_name = img_url.split('/')[-1]

if not os.path.exists('壁纸'):

os.makedirs('壁纸')

with open(os.path.join('壁纸', image_name), 'wb') as f:

for chunk in response.iter_content(chunk_size=1024):

if chunk:

f.write(chunk)

print(f'下载成功:{image_name}')

else:

print(f'下载失败:{img_url}')这段代码定义了两个函数:"download_page" 和"download_image"。"download_page"函数接受一个页面链接和代理IP字典,它使用"requests" 库发送GET请求到指定的URL,如果请求成功,它会使用 "lxml.etree" 解析HTML内容,提取所有带有"lazy" 属性的图片链接,然后对每个图片链接调用 "download_image"函数进行下载。

"download_image"函数接受一个图片链接和代理IP字典,它同样使用 "requests" 库发送GET请求,这次设置了"stream=True" 参数以支持流式下载大文件。如果请求成功,它会将图片保存到本地的 "壁纸" 文件夹中。如果 "壁纸" 文件夹不存在,它会先创建这个文件夹。图片下载过程中,它会以块的方式写入文件,每块大小为1024字节。

4.使用代理IP:编写函数来使用代理IP发送请求。

def download_all_pages_with_proxy(urls, proxies):

"""

使用代理下载所有页面的图片

:param urls: 页面链接列表

:param proxies: 代理IP字典

"""

for url in urls:

download_page(url, proxies)

# 示例代理IP(这里使用静态代理,实际使用时建议动态获取)

proxy_example = {

"http": "http://123.123.123.123:8080",

"https": "http://123.123.123.123:8080"

}

# 假设 urls 是已经生成的页面链接列表

urls = create_urls(page_number)

# 使用代理下载所有页面

download_all_pages_with_proxy(urls, proxy_example)四、注意事项

遵守法律法规:确保你的爬虫活动遵守目标网站的使用条款和相关法律法规。

尊重版权:下载的图片可能受版权保护,确保合法使用。

控制请求频率:合理设置爬取间隔,避免对目标网站服务器造成过大压力。可以使用time.sleep()函数来控制请求频率。

五、总结

通过上述步骤,你可以使用Python编写一个爬虫程序,批量下载高清美女图片。请确保你的爬虫活动合法、合规,并尊重目标网站的使用条款和版权。此外,通过合理设置请求频率和使用代理IP,可以提高爬虫的稳定性和可靠性。